La sensación generalizada es que, al parecer, la promesa de la inteligencia artificial se ha cumplido, que ha dejado de ser un fenómeno de científicos o de la literatura y que ya está disponible en cualquier dispositivo, lo sepamos o no.

> Leer también: Software que anticipa las inundaciones.

El nombre de la inteligencia artificial (IA) hoy es ChatGPT. La técnica o la publicidad así lo determinaron. Los tiempos actuales son así, virales se dice, no importa que la idea tenga setenta años y miles de proyectos anteriores o paralelos. Se trata de “una arquitectura de red neuronal profunda llamada GPT (Generative Pre-trained Transformer) que fue entrenada con grandes cantidades de datos textuales para poder generar respuestas coherentes y precisas a las preguntas y consultas de los usuarios”. Al menos eso es lo que respondió el propio Chat acerca de sí mismo. ¿De sí mismo?

ChatGPT fue la aplicación que más rápido crecimiento en número de usuarios tuvo en la historia de Internet. Como si se tratara de un gran estadio en el que se jugaba la final del mundo y las masas agolpadas afuera pudieran entrar sin pagar entrada. Así fue. Las más profundas curiosidades y temores nos movían. Sin embargo, esas cavilaciones concretas, a nivel de la técnica, esas ideas sobre una máquina que pudiera hacer lo que hoy hace ChatGPT comenzaron con una leyenda de la historia de la informática: Alan Turing, el que permitió iniciar el triunfo de los Aliados sobre los nazis mediante una computadora, la famosa Enigma (se puede ver el film Código Enigma de 2014). Luego de la guerra, Turing escribió el artículo “Maquinaria computacional e inteligencia” (1950) en el que se preguntaba “¿pueden pensar las máquinas?”. Ya nada sería igual después de ahí, de la apertura de esa “compuerta evolutiva” que tiene, aún, destino incierto.

La ciencia ficción comenzó a popularizar la pregunta, sobre todo en el cine. En las décadas siguientes se pudo conocer a la supercomputadora HAL9000 (del film 2001, una Odisea en el espacio, de 1968 y basada en la novela de Arthur Clarke) que consideraba a los humanos una amenaza para su existencia, o también al más afable androide C-3PO (Star Wars, 1977), que estaba siempre al servicio de las personas.

Sin embargo, las empresas apenas podían volcar en el mercado unos toscos artefactos informáticos, primero gigantes y luego más pequeños con la llegada del chip y la miniaturización en la década del ‘70. Las primeras PC de IBM empezaron a popularizarse a inicios de los ‘80 y aunque las revistas especializadas intentaban generar entusiasmo, las Personal Computer tardaron en ser vistas como algo útil.

Podía computarse, bastante, pero claramente no era lo mismo que pensar. Uno de los pioneros de la inteligencia artificial, Marvin Minsky (MIT), respondía de este modo a las dudas y el escepticismo mediante un artículo publicado en 1982: “La mayor parte de la gente asume que un ordenador no puede ser consciente de sí mismo; que como mucho, pueden simular que lo son. Por supuesto, esto está basado en la suposición de que los propios humanos somos conscientes de nosotros mismos. Pero, ¿lo somos? No lo creo”, desafiaba. Y apostaba por un crecimiento mutuo: humanidad y máquinas del mundo, a unirse. “Tal y como la evolución cambió nuestra forma de ver la vida, la IA cambiará la visión sobre la mente. A medida que encontremos más caminos para que las máquinas se comporten de un modo más sensible, aprenderemos más sobre nuestros procesos mentales”. El resplandor de una utopía cibernética que no terminaba de nacer.

El crepúsculo de los dioses

El 22 de marzo de 2023 es el día D (por utilizar la metáfora bélica de los tiempos de Turing). Se conoció una carta abierta titulada “Pausar experimentos gigantes de IA” (Pause Giant AI Experiments: An Open Letter) publicada por el instituto Future of Life. El texto se viralizó más rápido que una extravagante tropelía de Donald Trump. Fruto de un encuentro ecuménico, la carta está firmada por miles de personalidades (cerca de treinta mil intelectuales, empresarios, activistas), en la cual firman desde magnates como Elon Musk (Tesla/Twitter) y Steve Wozniak (Apple), pasando por investigadores de la IA como Ramana Kumar (Google DeepMind) o Emilia Javorsky (directora de la organización de científicos contra armas autónomas), y hasta filósofos best seller reconocidos por su postura crítica a la IA, como Yuval Noah Harari. Su pedido era simple: “Hacemos un llamado a todos los laboratorios de IA para que pausen inmediatamente durante al menos 6 meses el entrenamiento de los sistemas de IA más potentes que GPT-4”.

Al instante, todas las luces, las de alarma y las de la publicidad, se encendieron. ¿Qué era GPT? ¿Era el verdadero nombre de la famosa Skynet que anticipó el film Terminator? ¿Qué hacemos en seis meses?, ¿esperar el fin del mundo?

¿Entrevisté?, a una red neuronal. Pregunté a GPT mediante su interfaz de chat, y no sin temor a que se ofendiera, lo siguiente: dicen que sos la mejor IA del mundo, ¿es así? En tono neutro, respondió: “ChatGPT es parte de una nueva generación de modelos de lenguaje que han logrado avances significativos en la capacidad de la inteligencia artificial para entender y generar lenguaje natural”. Ante mi insistencia periodística, tuvo que agregar algo: “La popularidad de ChatGPT se debe a su capacidad para generar respuestas coherentes y útiles a una amplia variedad de preguntas y consultas, lo que lo hace especialmente útil para tareas como la asistencia al cliente, la investigación en línea y la educación”. Seguimos hablando un largo rato, yo me cansé primero, así que le agradecí y me respondió: “Estoy aquí para ayudarte en lo que necesites. ¡Que tengas un buen día!”. Tuve una sensación similar a la primera vez que usé un chat en tiempo real por computadora (quizás alguien se acuerde del viejo ICQ), pero esta vez no estaba eufórico, era otro el sentimiento, más indescifrable.

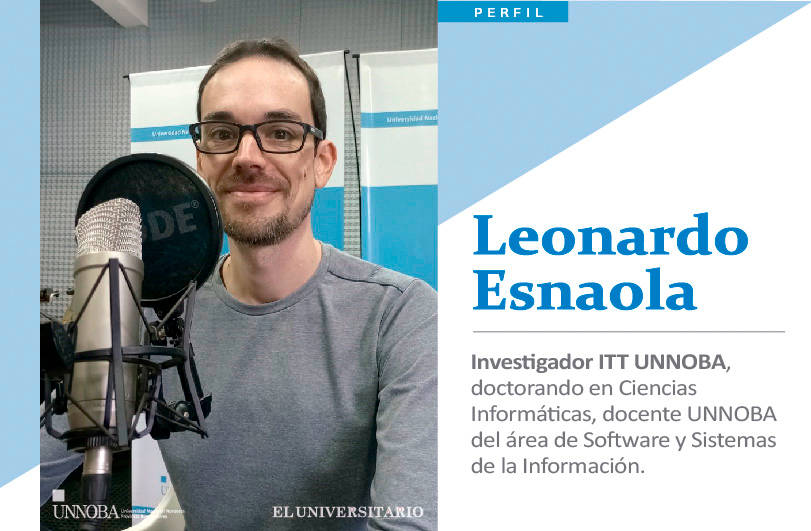

Tenía que chequear con un humano esta información. Además, me seguía dando vueltas la posibilidad de que estuviéramos frente a una gran campaña publicitaria, un vicio profesional, sobre todo porque detrás estaba la empresa Microsoft. Con estas preguntas y otras dudas recurrí a nuestro experto en IA, Leonardo Esnaola (Investigador del Instituto de Investigación y Transferencia de Tecnología de la UNNOBA -ITT-, doctorando en Ciencias Informáticas, docente del área de software y Sistemas de la Información). Después de recordar algunos detalles de anteriores entrevistas, Esnaola se puso serio, se acomodó la incipiente barba y espetó: “Sí, esto es algo distinto”.

Red neuronal: “El porvenir de una ilusión”

“Estamos en el campo de la inteligencia artificial generativa, una inteligencia artificial que puede generar cosas, ya sean textos coherentes como hace ChatGPT, una IA generativa de imágenes, o de otros tipos de contenidos”. Esnaola destaca la diferencia con los modelos anteriores, porque la IA generativa puede tomar datos sin etiquetar, es decir, sin la participación de un humano que le dice cuál es el significado o qué debe hacer con esa información (ver Altoritmo, divino tesoro).

“Recoger datos etiquetados lleva un tiempo, un costo, tener a alguien –un humano– trabajando, y eso hace que no puedas tener bases de datos demasiado grandes porque hay que contratar personas”. Este nuevo paradigma de aprendizaje, el generativo, se entrena mediante la ausencia de palabras y la predicción: tiene que encontrar la palabra que falta en un hueco. “Como vos ya tenés la respuesta correcta, que es la palabra que borraste, eso lo usás para entrenar la IA. Ese es el enfoque de Bard (de Google), que es autosupervisada. En GPT, en vez de borrar una palabra, borran la terminación de una frase. La IA es entrenada para predecir las palabras, examinar el contexto de las palabras y trata de predecir y completar la frase”.

El abandono de la supervisión humana y el cambio en el modelo de entrenamiento no es el único factor. Aparecen más vetas. En los feeds de noticias de mi teléfono aparece la noticia: “Google desarrolla una inteligencia artificial generalista y dice estar más cerca de alcanzar la humana”. Esnaola opina que “los modelos generativos tienen un cierto propósito general, se está hablando de eso, pero es algo difícil de medir aún”. Y ejemplifica: “Las tareas que son complejas para el ser humano, como el cálculo, la máquina las hace bien, pero las tareas como comunicarnos o mirar el cielo y saber si está nublado, esas que parecen simples, para una computadora no lo son, requieren de un conocimiento del mundo. Estas herramientas se están metiendo, justamente, en ese terreno”.

Esnaola afirma que al menos la carta abierta publicada en Future of Life plantea que es un camino difícil de manejar “porque hay una competencia entre empresas líderes que fogonean tecnologías que quizás se publican antes de lo que deberían, por el hecho de competir comercialmente”. Hoy OpenAI (vía Microsoft) y Google son los que llevan la delantera, claramente. Pero Esnaola advierte que “es cuestión de tiempo para que salgan otras empresas a jugar, mejorar, optimizar y competir”. De hecho, la tecnología que hay por detrás de los modelos de GPT la propuso Google originalmente. “El proceso, de alguna manera, se fuerza en esta competencia y así se descontrola”.

Libertad de mercado y gobierno

Para abordar este aspecto consulté a Martín Gendler, doctor en Ciencias Sociales (UBA) y profesor de Sociología. Él viene estudiando temas como la “Gobernanza de Internet” y los impactos de las nuevas tecnologías en la sociedad. Gendler es contundente: “GPT rompió el delicado equilibrio que hay en el capitalismo de plataformas”. Incluso más: “Las plataformas de la actualidad generan un ecosistema con segmentos definidos en el que cada empresa tiene una parte con dominación, y pequeñas presencias en los otros. Sin embargo, a la vez, todas estas empresas vienen trabajando e investigando en todas las líneas posibles, como inteligencia artificial, realidad aumentada o internet de las cosas. Lo que nadie esperaba es que, sobre una de estas cuestiones (IA) una de estas empresas (OpenAI) diera un salto tan grande y por eso están temerosos”, indica.

El primer modelo red neuronal profunda del modelo GPT fue lanzado en 2018: “Podía almacenar su aprendizaje en función de algo más de cien millones de parámetros”, cuenta Esnaola. “GPT2, lanzado en febrero de 2019, ya pasa a miles de millones de parámetros, es decir, que creció exponencialmente. Con cada generación que sale, crece su poder de cómputo y alcanza textos más coherentes”, explica. Esta interfaz que está conmoviendo a la humanidad, Chat-GPT fue lanzada en noviembre de 2022 y en pocos meses, marzo de 2023, se lanzó GPT-4, el nuevo modelo. La empresa OpenAI, a diferencia de lo sucedido con modelos anteriores no publicó las características, por lo tanto no se sabe qué tan grande es.

Todo chat es ideológico

Esnaola explica que la gran novedad es que antes, para conversar con GPT o cualquier otro modelo similar, había que instalar un software y tener conocimientos de informática. Ahora, al introducirle una interfaz tan simple como un chat que cualquier usuario de internet sabe usar, cualquiera puede preguntar. Al mismo tiempo esa interacción le va brindando un entrenamiento (aprendizaje) a la red neuronal. El límite y hasta dónde se lo puede usar y puede aprender se está viendo en la práctica misma, a medida que la inventiva de las preguntas lo hace avanzar. La incertidumbre está presente.

El modelo de chat o conversación con la máquina se remonta al icónico “Test de Turing” (sí, por Alan Turing, el de Enigma). El test dice que si una computadora puede manejar el lenguaje de modo que un humano, desde atrás de un canal conversacional, no puede distinguir si habla con una persona o con una máquina, entonces, se afirma que estamos ante un comportamiento inteligente.

Lenguaje e inteligencia unidas detrás de un ordenador. Fue demasiado para el filósofo Yuval Harari, quien tomó la bandera de la humanidad y encaró hacia las trincheras enemigas: “La IA tiene la capacidad de hackear y manipular el sistema operativo de la civilización. Al adquirir el dominio del lenguaje, la IA se ha apoderado de la llave maestra de la civilización”.

Cuando el siglo XX se despedía, había ocurrido un hecho de parecida resonancia mundial al actual incidente GPT. Tal vez no resultó tan paradigmático como para convertirse en una compuerta evolutiva, pero Deep Blue (la máquina de IBM que había sido entrenada en el ajedrez, durante los años 1996 y 1997) jugó una serie de partidas contra el campeón mundial de este deporte, el ruso Gary Kasparov, y le ganó. “Pensar es calcular”, había pronunciado Gottfried Leibniz trescientos años antes. Deep Blue le dio sentencia de muerte a su idea. La máquina ahora podía hacer los mejores cálculos. Pero entonces, ¿qué era pensar? Nos quedaba, aún, el refugio del lenguaje.

Al utilizar nuestro lenguaje, “la nueva IA está interviniendo directamente en el proceso social de creación de significado”, por lo tanto, “los sistemas GPT son máquinas de ideología”, afirma el investigador en tecnología digital, Leif Weatherby. El aspecto ideológico de algoritmos e IA viene siendo abordado desde la categoría de “sesgo” (bias en inglés). Los problemas de sesgo aparecen cuando los programas informáticos favorecen cierto tipo de respuestas frente a otras. ¿Cómo se dan esas “preferencias” que muchas veces se muestran como recomendación? Son los algoritmos inteligentes los que toman las decisiones, ¿o las empresas deben responder por sus diseños? Lo cierto es que a partir de la generación de lenguaje y creación de significado la categoría de sesgo parece quedar corta. Es lo que parecerían estar planteando Harari y Weatherby.

Una caja negra para tu Navidad

La carta abierta de Future of Life habla de “modelos de caja negra impredecibles, cada vez más grandes con capacidades emergentes”. Si la creación de significado está sujeta a lo impredecible, ¿debemos asumir que hay una parte del funcionamiento del modelo generativo de la IA al que no podemos acceder?

“Sí”, responde Esnaola. “En realidad sólo vemos el funcionamiento a nivel sistémico, por lo tanto, hay entradas y salidas a una caja, que es el sistema. Si querés ver cómo se transforma esa entrada en una salida, en este tipo de tecnología como son las redes neuronales, no lo sabés, porque lo que guardan son ‘pesos’ o valores que ponderan transformaciones matemáticas que podemos leer pero que no nos van a dejar descubrir por qué hace lo que hace”. Es decir que se pueden ver los valores o datos usados por el sistema, pero no los podemos interpretar. Por lo tanto, no sabemos qué es lo que está sucediendo ahí adentro, en la black box.

“Esto es muy distinto a los modelos anteriores”, enfatiza Esnaola. En la programación tradicional se establecen los mecanismos para seguir un camino u otro (mediante “reglas” de decisión). En cambio, “este tipo de elementos, acá, no los ves”.

Es por eso que espacios como la Fundación Vía Libre se han expresado en contra de lo que plantea la carta abierta: “Esta gente está pidiendo que se pause la investigación y no la aplicación. Lo que efectivamente puede hacer mal es la aplicación de estos sistemas, no que se investiguen. De hecho, que se investiguen debería ser positivo para que se entienda mejor cómo funcionan”.

Trabajo y máquinaria: por el camino de Ned Ludd

Culpar a la tecnología como la causante de un proceso social, no es algo nuevo. Lejos en el tiempo se hizo célebre Ned Ludd, el personaje que supuestamente fue el primero en destruir una máquina de hilar en la Inglaterra de la Revolución Industrial. Los artesanos se quedaban sin trabajo frente a la nueva técnica, y una de las respuestas que encontraron para protestar fue destruir las máquinas.

Una de las preguntas que me llevó hacia Martín Gendler tenía que ver con este tema: ¿cómo se prepara la sociedad de la información para enfrentarse a un posible mundo sin trabajo? “Desde la época de la Revolución Industrial sabemos que cada nueva ola de desarrollos tecnológicos plantea transformaciones en relación a esperanzas y temores. Uno de los ámbitos en los que se ven ambas cosas, es el laboral”, reflexiona Gendler. “Desde aquellos tiempos se planteaba la idea de mejorar procesos, optimizar tiempos, espacios, cantidad de producción y también se sabía que podía dejar en el desempleo a muchas personas; y esto lo podemos rastrear hasta en la literatura, como en Charly y la fábrica de chocolate, donde todos los trabajadores son reemplazados por uno, el encargado de verificar que cierre bien la cajita”.

El fin del trabajo humano es una distopía que cobra más fuerza a medida que la maquinización y el automatismo crece. Gendler comenta que el fin del trabajo se relacionó con la informática desde los comienzos mismos de internet, cuando la red tenía menos de diez años de vida y menos de doscientas mil personas conectadas. “Ahora estamos en una época en la cual, aunque hay una mayor magnitud de uso de la tecnología digital, la cuestión es la misma: surge una innovación disruptiva y aparecen las esperanzas y los temores”.

“Desde que las tecnologías digitales impactan en el mundo del trabajo, los expertos plantean que se viene acrecentando la división social del trabajo en dos polos: el polo hipercalificado, con habilidades y acceso a tecnologías, y el polo hiperprecarizado”, detalla. Según el docente, se lo puede plantear de modo más simple aún: están quienes diseñan la tecnología y quienes la ensamblan. “El trabajo creativo e intelectual siempre tuvo mejores condiciones que el manual pero, en esta época informacional, la brecha se acrecienta, por eso utilizamos el término hiper delante de calificado y precarizado”, sentencia.

“Con la inteligencia artificial se sigue el mismo patrón. ¿Quiénes pueden hacer un uso creativo y hasta lucrativo de estas tecnologías?”, pregunta Gendler. Las empresas que monitorean el flujo de usuarios en internet informaron que ChatGPT fue la aplicación que más rápido crecimiento tuvo en la historia de internet. Sin embargo, ¿son usuarios o tan solo personas motivadas por la curiosidad? Para Gendler, “cuando estas tecnologías se vayan introduciendo como obligatorias en el ámbito laboral, van a magnificar aún más esta brecha entre tipos de usuario. La diferencia estará no sólo en poder acceder o tener una habilidad básica, sino que habrá que tener el conocimiento específico para sacarle ‘todo el jugo’. Por lo tanto, probablemente el segmento de los trabajadores hipercalificados sea cada vez más segmentado y más pequeño, especialistas en estas cuestiones, y muchos otros que hasta ahora eran calificados pasen a ser parte del proletariado informacional”.

Hija de la definición clásica de proletariado (quienes sólo disponen de su fuerza de trabajo y la venden en el mercado para poder sobrevivir), la de proletariado informacional irrumpe en el capitalismo de las plataformas: “Hoy ese proletariado son los chicos de Pedidos Ya, de Uber o los que mueven las cajas en Mercado Libre —indica Gendler—. Pero con estos avances recientes, ese proletariado se va a ampliar, por ejemplo con la incorporación de los programadores. Si estas tecnologías hacen lo mismo que diez programadores, ¿quién será el hipercalificado? La persona que tenga la habilidad necesaria. El resto se encargará de arreglar algún fallo”.

Un ensayo para el gobierno civil

Empresas como Microsoft, Meta (Facebook) o Alphabet (Google), disponen de una inversión para la investigación difícil de dimensionar. En el marco de este proceso de competencia entre gigantes, surge la pregunta sobre la posibilidad de una regulación o “gobernanza” en este terreno. ¿Admitirían estos gigantes ser regulados?

Al respecto, Martín Gendler afirma: “Más allá de la posibilidad, creo que es totalmente deseable y que el único camino posible es el de la gobernanza”. La idea, que viene de la ciencia política y es muy aplicada a cuestiones derivadas de internet y las nuevas tecnologías, involucra no sólo al Estado de modo aislado para llevar adelante la regulación. “Por la magnitud global, y porque hay muchísimos conocimientos que no se tienen —plantea Gendler—, la idea de la gobernanza implica que todas las partes interesadas, con capacidad de acción y que tienen algo para decir, puedan juntarse y decidir cómo operar. Esas partes son, además del Estado, el sector privado, la sociedad civil y el sector técnico. La gobernanza se enriquece de los aportes de cada uno de los sectores”.

Con la inteligencia artificial sucede algo muy curioso: no existe a nivel mundial marco regulatorio alguno. En mayo de este año, Sam Altman, el director ejecutivo de OpenAI, se presentó ante el Senado de los EE.UU. y dijo que “regular la inteligencia artificial es crucial”. Gendler aclara que existen variedad de declaraciones, guías, marcos éticos o planes de políticas públicas con recomendaciones, pero no existe “ninguna ley”. “Si la inteligencia artificial tiene más de sesenta años, ¿por qué pasa esto?”, inquiere.

“El consenso que había hasta ahora, el de las empresas que se autorregulan, se cae con el escándalo de Cambridge Analytica (2017) porque se pensaba que era lo mejor que se podía hacer, que si el Estado se metía iba a arruinarlo. Se le dio todo el poder a las plataformas”, pondera el sociólogo.

Hay pocos países en el mundo con organismos institucionalizados y con una lógica de gobernanza que puedan asegurar el cumplimiento de “líneas guía”. “Uno de los países que aplica la gobernanza es Brasil, mediante el Comité Gestor de Internet (cgi.br), que nació en 1995 y que entre sus miembros tiene representantes de todos los sectores”. Para Gendler, “hay muchos marcos internacionales dentro de los cuales la gobernanza de la IA se podría gestar, pero no se está haciendo”.

¿Entonces el pedido de “suspender la investigación” podría ayudar en este sentido? Para el investigador social, parece que “este tipo de empresas se preocupan por los derechos humanos, cuando en realidad ven un riesgo económico muy fuerte para ellos, y no por una mala decisión propia, sino porque otro actor (OpenAI) les sacó gran ventaja”.

El copiloto menos esperado

Con la compra de OpenAI, Microsoft dio el salto. ¿Cuándo impactará en sus productos? Ya lo estamos viendo. Este artículo está ilustrado con imágenes “creadas” con Bing Image Creator a partir de textos. “Quiero ver una rivalidad entre IA y la matrix”, o “un humano alienado por las redes”, y con esas frases Bing hace lo suyo. Se trata de una tecnología denominada DALL-E (nótese el juego de palabras), una IA generativa de imágenes impulsada por OpenAI.

“Hace mucho tiempo que Microsoft está tratando de integrar esta tecnología a sus productos. De hecho, a pocos días de lanzar GPT-4 hicieron un evento en el que anunciaron que habían introducido IA del modelo generativo en Office, por ejemplo con un programa denominado Copilot”, indica Esnaola. ¿No puedo estar en la reunión a la que me convocaron? Copilot hace un resumen de los temas principales, porque está conectado al flujo de audio, lo transcribe, o hace el resumen y si escuchó que la próxima semana hay otra reunión, pregunta si hay que agendarla. “Los avances van a venir no tanto por el tamaño del modelo, sino por la potencialidad de uso, que son cosas distintas”. La imaginación (tecnológica) al poder.

“A medida que se van masificando, las tecnologías se van naturalizando”, considera Gendler. “Cuando trabajo con estudiantes de primer año de la universidad y les hablo de lo que implicó la aparición del smartphone, muchas veces no lo entienden, porque ya está naturalizada su existencia. Resulta difícil imaginar una sociedad previa porque muchas veces se impulsan andamiajes discursivos que sostienen que lo tecnológico es el progreso”.

Nuestros sueños más valientes o las pesadillas más crueles muchas veces se manifiestan mediante obras literarias, y con gran anticipación. Retratos de un espíritu de época que nos invade, ideas fantasmagóricas que se transforman, gracias a la imaginería técnica, en una inventiva o en el simple despliegue de las fuerzas sociales frente a lo inevitable.

> Leer también: Polo Tecnológico Junín, un centro de avanzada.

Mientras escribía este artículo encontré una vieja antología de cuentos de ciencia ficción publicada en Argentina, allá por 1975. Me sorprendió el cierre del libro, el último párrafo del último de sus cuentos (“Café molecular”, de I. Varshavski), casi una premonición para cerrar el libro: “Cuando me desperté resultó que todas estas tonterías del café las había soñado, y entonces escribí este cuento; pues me parece que si dejamos sueltos a los cibernéticos, el resultado no puede ser muy bueno. Es necesario que la gente no los pierda de vista”.